GRAPH-BERT: Only Attention is Needed for Learning Graph Representations

GRAPH-BERT: Only Attention is Needed for Learning Graph Representations

当前GNNs的主要方法是过度依赖图中的连接关系,这样造成了三大问题。

- 模型假死 (suspended animation problem) : 随着神经网络层数的不断加深,模型对于输入的数据开始不进行反应。这个问题的原因论文没写,个人理解是由于层之间的非线性使得数据分布变换导致梯度消失。

- 过平滑 (over-smoothing problem) : 由于GNN大多依靠聚合操作 (mean,max,sum) 的信息更新方式,这样随着层的不断堆叠,每个节点都会大量收到其他信息节点的影响,从而使得每个节点的embedding预测趋同。

- 难以并行计算:由于内存的限制,尤其是在大型图里面,图中的关联关系难以并行计算。

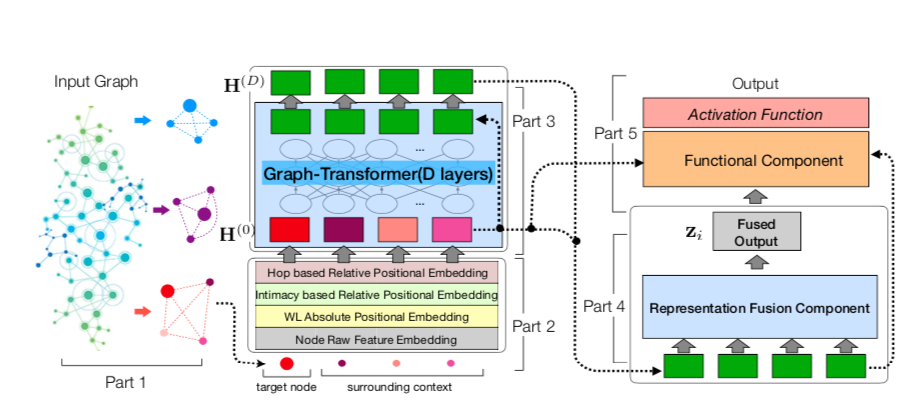

根据以上问题作者提出了一种新的图神经网络,即Graph-Based BERT,它完全基于注意力机制,不需要任何图卷积或聚集操作。

在模型输入部分,不会把一整个大图输入给模型,而是先采样得到大图的一些无边子图,只是抽取子节点,而不考虑这些节点之间的边关系。这样就解决了GNN不能并行的问题。

传统GNN由于图的结构多样性,不能进行跨任务的预训练工作,但Graph-Bert不考虑边之间的联系,因此并不受限于图结构,可以很好地进行预训练和迁移学习。

Method

符号定义

无边子图采样

输入节点向量Embedding

原始特征embedding

Weisfeiler-Lehman 绝对角色 Embedding

基于亲密度的相对位置Embedding

基于相对距离的Hop Embedding

Graph Transformer Encoder

预训练任务

节点原始属性重构

图结构恢复

评论

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Coding-Zuo!