TRANSFORMER-XH: MULTI-EVIDENCE REASONING WITH EXTRA HOP ATTENTION

TRANSFORMER-XH: MULTI-EVIDENCE REASONING WITH EXTRA HOP ATTENTION

摘要

提出Transformer-XH配有eXtra Hop attention以完全数据驱动的方式实现了结构化文本的内在建模。

完全数据驱动应该是指不仅可以处理序列结构的数据,还可以处理图结构。

eXtra Hop attention 除了关注每个序列内的记号外,还可以连接的文本序列之间跳跃

因此文档之间传播信息和构建全局上下文表示来更好地进行联合多证据推理。

eXtra Hop attention的作用:

- 当每段文本与其他证据相关时能够更全局地表示每段文本所贡献的证据

- 以一种自然的方式,通过必要的边信息传递对证据图联合推理

方法

面临的第一个挑战就是由于transformer的softmax计算在所有token对上,很难处理长文本。

Transform-XL(eXtra Long) 通过将更长的文本(多段落文档) 分解成文本段序列 $\lbrace X1,…,X_r,…,X{\zeta} \rbrace$ 来解决。

使用如下的公式计算在相邻文本段之间传播信息:

其中 $H_r^{l-1}$ 表示第 r 个文本段的第 $l-1$ 层Transformer表达。

新注意力机制中的 $Q,K,V$ 就表达为:

之后就还是送到缩放点积中。这一点处理长文本可能是参考了TransformerXL。

Transformer-XL 的重要组件之一,Segment Recurrence Mechanism(段循环机制)想做的就是,能不能在前一段计算完后,将它计算出的隐状态都保存下来,存到一个 Memeory 中,之后在计算当前段的时候,将之前存下来的隐状态和当前段的隐状态拼起来,作为 Attention 机制的 K 和 V,从而获得更长的上下文信息

然而,在许多情况下,文本段被组织在线性序列之外的结构中。例如,文档由图形结构中的超链接连接,这种图形结构不容易简化为形成线性序列,从而禁止了Transformer-XL的递归方法。

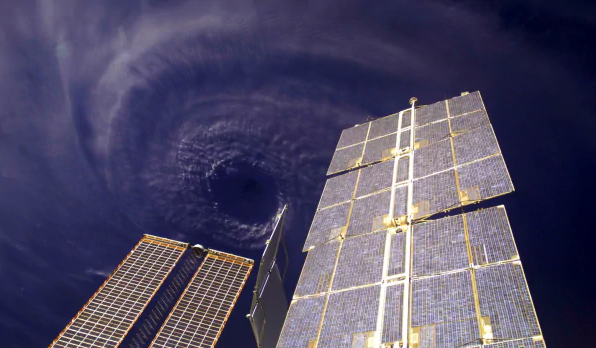

下面将引出eXtra Hop attention 如下图

图a 表示 三个链接的文档 $d_2,d_1,d_3$ . Transform-XH使用eXtra Hop attention沿图形边缘传播信息,从而在连接的文本序列之间实现信息共享。

结构化文本包含一些列节点 $ X =\lbrace X1,…,X_r,…X{\zeta} \rbrace$ , 对应于一个文本序列。

目标是生产表达 $X =\lbrace \hat H1,…,\hat H_r,…\hat H{\zeta} \rbrace$ ,其不仅合并了每个序列 $X$ 中的本地信息,而且还合并了关于整个结构化文本 ${X,E}$的全局上下文。

Transform-XH通过两种注意机制来实现这一点:in-sequence attention 和 eXtra Hop attention。

in-sequence attention 和 Transformer一样, 在 $l$ 层,第 $i$ 个token 收集从同一文本段τ内的其他 token 的信息:

eXtra Hop attention, 使用第 CLS token 作为 attention hub ,在 $l$ 层,第 $\tau$ 个文本序列,如果 $τ$ 文本序列与另一个文本序列η之间存在边( $e_{τη}=1 $) :

节点 $τ$ 使用hop query $\hat q{r,0}$ 和 key $\hat k{\eta, 0}$ 计算其邻居 $η$ 上的关注度权重,然后乘以邻居的value $\hat v_{\eta,0}$ ,最后将两个注意力机制聚合起来得到新的 $l$ 层的表达:

$ i \ne 0$ 是 non-hub tokens

一层 eXtra Hop attention 可视为沿着边 E 信息传递的 single-step

例如,在图a中,文档节点 $d_3$ 通过使用hop attention , $d_1→d_3$ 从其邻居d1收集信息来更新其表示。当多个Transformer-xh层被堆叠时,$d_1$ 中的该信息包括来自其in-sequence attention 的 $d_1$的本地上下文,以及来自 $ l-1$ 层的 hop attention ,$d_2−d_1$ 的交叉序列信息。因此,L 层 Transformer-XH可以处理最多 L 跳以外的信息。

总之 Transformer-XH共有三个主要属性,可对原始结构化文本数据进行有效建模:

- 信息沿边的传播

- 信息的重要性 (hop attention)

- 序列内和跨序列信息的平衡 (attention combination)

在 $H$ 中学习的表示可以天生地表达结构化文本中的细微差别,这些细微差别是复杂的推理任务(如多跳QA和自然语言推理)所需的。